Tramontando l’etere luminifero nel cielo scientifico sorsero altri astri, la fisica divenne sempre più “metafisica” affidata nel suo sviluppo, quasi esclusivamente, alla formalizzazione matematica ed ai risultati quantitativi che via via ne derivavano. Sempre meno rimase sospesa tra intuizione e logica a tentare di cogliere il mistero unitario del Mondo, corroborata, nei passaggi più scabrosi, anche dal criterio di analogia. Del resto gli scienziati “eteristi” si erano dimostrati un po’ ingenui nell’utilizzarlo (con il senno del poi) ed i successori, relativisti e quantistici non ne ebbero più bisogno, quest’ultimi impegnati a tracciare la mappa del labirinto sub-atomico, peraltro da essi stessi riconosciuto mutevole sotto la pressione dell’indagine.

Sopratutto si affermò il criterio di considerare i fenomeni naturali, dalla microfisica alla chimica, alla biologia e via salendo, in quanto tali, e non come effetti di cause che potevano essere lette tra le righe dei medesimi fenomeni. Questo concetto, difficile da esprimere, è reso con sconcertante chiarezza da R.P.Feynman; fisico premio Nobel nel 1965, nell’introduzione ad una raccolta di sue conferenze sull’elettrodinamica quantistica, il suo campo di ricerca:

“Io descrivo il comportamento della natura ma se a voi questo comportamento non piace, il vostro processo di compressione ne risulterà intralciato. I fisici hanno imparato a convivere con questo problema: hanno cioè capito che il punto essenziale non è se una teoria piaccia o non piaccia, ma se fornisca previsioni in accordo con gli esperimenti. La ricchezza filosofica, la facilità, la ragionevolezza di una teoria sono tutte cose che non interessano. Dal punto di vista del buon senso l’elettrodinamica quantistica descrive una natura assurda. Tuttavia è in perfetto accordo con i dati sperimentali. Mi auguro quindi che riuscirete ad accettare la Natura per ciò che è: assurda.

[…] Ascoltatemi fino in fondo e ne sarete incantati anche voi”

Nonostante la premessa, quest’ultima esortazione lascia trapelare, insieme alla sua biografia, che Feynmann fu comunque un personaggio “luminoso”: appassionato insegnante e divulgatore, non si limitò a celebrare l’astrusità della fisica moderna, come altrove spesso accade, ma cercò anche di documentare nel modo più chiaro e semplice possibile, i suoi passi teorici. Egli utilizzò un sistema formale, quasi esclusivamente grafico, per descrivere e far funzionare sulla lavagna o su un foglio di carta, il mondo dei quanti; il suo lavoro di ricerca, insieme a quelli convergenti di altri due colleghi, pose la pietra d’angolo della QED (elettrodinamica quantistica) nel 1948. Poco meno di vent’anni dopo, superate numerose verifiche sperimentali, la teoria dei quanti valse ai tre il premio Nobel, nel 1965. Era ormai trascorso circa un secolo dalle equazioni di Maxwell; in apparenza, le vie su cui si era sviluppata la ricerca, divergevano nettamente dal luogo mentale in cui sembrò possibile descrivere la tessitura del mondo fisico in termini di continuità ondulatoria ed al proposito Feynman, com’è suo costume, non indugia in giri di parole:

“ho parlato del fotomoltiplicatore per illustrare un aspetto essenziale che forse non vi era noto, cioè che la luce è fatta di particelle ma spero che anche su questo non ci siano più dubbi.”

I presupposti di questa affermazione sono già tutti contenuti nelle pieghe dell’esito dell’esperimento di M&M un secolo prima:

-

Venendo a mancare l’etere, una preesistente, piccola crepa della teoria ondulatoria, non ancora risolta, acquistò rilevanza e si sarebbe allargata sempre più, attirando i rivoli della ricerca. Essa è costituita dal fatto che sottoponendo a rilevazione un flusso elettromagnetico in via di attenuazione, con l’apparecchiatura sopra citata: il fotomoltiplicatore, si constata che detto flusso si dirada per punti discreti anziché attenuarsi in modo continuo; cioè un segnale acustico generato elettricamente al passaggio di un flusso luminoso non si fa più flebile attenuandosi, sino a cessare ma, conservando la medesima intensità, si dirada sino a divenire un ticchettio che rileva il passaggio, sempre più distanziato, di singoli quanti luminosi: i fotoni.

-

La teoria ondulatoria non è in grado di dar conto di ciò sebbene sia adatta a spiegare gli altri fenomeni ottici, complessi e mirabili, come la comparsa dei colori prismatici e l’arcobaleno, le riflessioni parziali o le risonanze che permettono le trasmissioni radio.

R.P.Feynman concluse il suo ciclo nel 1988, non possiamo quindi chiedergli se, veramente, ritenesse la natura assurda come la dipinse; ma dopo averlo seguito nel labirinto da lui predisposto ed aver superato alcuni disagi mentali, come quello di dover rivedere in termini discreti fenomeni conosciuti, sin dai tempi scolastici, come ondulatori, ci si ritrova a considerare che l’umanità è nuovamente di fronte a quella soglia decisiva, su una superiore voluta della spirale e che dispone di nuove risorse mentali per, quantomeno, socchiudere la porta.

Il sistema formale di Feynman consiste in vettori (frecce, come lui amichevolmente le chiama) che, costruite ed orientate sul piano secondo poche regole, sempre ricorrenti, definiscono una risultante, il cui quadrato indica “l’ampiezza della probabilità” che una certo evento fisico, un fenomeno di riflessione ad esempio, si manifesti emergendo da una nuvola di altre sue configurazioni egualmente plausibili e reali. Questa ampiezza varia tra la minima e la massima probabilità; vale a dire che oscilla: il fronte di quest’onda disegna la cosiddetta realtà e, sebbene in modo un po’ elusivo1, le perturbazioni elettromagnetiche ne ricalcano la traccia.

Così il “quanto” è il qui ed ora di un ovunque e sempre, il precipitare di una certa simmetria o “intenzione”. Si può aggiungere che quando l’ampiezza della probabilità del manifestarsi di una parte è al minimo, è al massimo quella di cogliere la realtà del tutto, che dal punto di vista dei qui ed ora già manifesti, appare come “Vuoto” pur essendo più sostanziale di quella che chiamiamo “Realtà”.

La teoria dei quanti si presta a molti paradossi che spesso velano ciò che essa offre di più prezioso: l’identificazione unitaria della realtà a partire dai suoi infiniti frammenti, la cui somma, però, non basta a rappresentare l’intero (olismo). Non esiste altro flusso teorico che, come questo, abbia dato origine a tante diramazioni esterne alla microfisica, specialmente nella filosofia della conoscenza e nella psicologia umana. Ad esempio, dalla collaborazione tra Wolfang Pauli, tra i fondatori della fisica quantistica, e Carl Jung scaturì il concetto di sincronicità: ossia la teorizzazione di quell’insieme di eventi che accadono, in violazione alle regole dello spazio e del tempo a noi note e fondanti il modello empirico del mondo. Classico esempio che viene citato è il pensare ad una persona conosciuta, anche se non necessariamente significativa nella propria esperienza personale, e poi incontrarla. Ma si danno casi più mirabili, come il contemporaneo ed in apparenza indipendente, convergere di una medesima formula mentale, in ambiti di ricerca separati.

Ma ci siamo spinti troppo oltre; abbiamo tralasciato un altro aspetto della fisica che fu ulteriore conseguenza dell’esperimento “fallito” di M&M

-

Quell’esito implicava il fatto che la velocità di propagazione della luce, nel così detto vuoto, fosse una costante universale (il cui simbolo in fisica è “c”, circa 300. 000 Km/s). E’ curioso che, sino ad allora, la costanza della velocità della luce fosse ritenuta un serio indizio, quasi una prova, del fatto che lo sviluppo delle onde elettromagnetiche avvenisse in un etere che, con le sue caratteristiche fisiche di densità ed elasticità, ne condizionasse lo sviluppo spaziale. Ma in base alla relatività galileiana una tale velocità doveva risultare componibile con quella di un osservatore in moto e questi erano appunto i presupposti di M&M.

-

Ma non era così; riprendendo l’analogia del temporale mentre la velocità apparente del tuono deriva dalla somma o dalla sottrazione dei 340 metri al secondo con la velocità di avvicinamento o di fuga dell’osservatore dal fronte sonoro, il bagliore del fulmine che ha originato quel tuono viaggerà verso l’osservatore a 300.0002 Km/s. Sempre! Sia che esso si avvicini o che fugga dal luogo dell’evento. Questo è il vero risultato concettuale dell’esperimento M&M che mise in crisi, definitivamente, la relatività galileiana.

All’inizio del XX secolo un impiegato all’ufficio brevetti di Berna, sconosciuto ed isolato dalla comunità scientifica dell’epoca, riuscì a pubblicare tre articoli scientifici inerenti una sua ricerca eseguita a partire da alcune contraddizioni tra la teoria elettromagnetica e quella gravitazionale. In essi egli sconvolse i concetti di “Spazio” e “tempo”, sino ad allora ritenuti enti fondamentali ed immutabili. Un po’ come notificare ad un nocchiero che la sua rotta si è basata su un punto cospicuo fallace: un monte innevato all’orizzonte che in realtà è un iceberg in balia di venti e correnti.

Era nata così la relatività moderna ad opera di Albert Einstein, in essa la misure del mondo fisico sono relative allo “stato” dell’osservatore, ad esempio due viaggiatori che si spostano a velocità differenti ottengono misure del loro spazio e del loro tempo proporzionalmente differenti. Ciò non è evidente nella nostra realtà empirica perché le interazioni avvengono per frazioni esigue di “c”. Einstein fornì, quindi, la descrizione del mondo fisico oltre il picco di apparenze che costituiscono l’esperienza sensibile e la formalizzò in termini matematici; nel 1916 la teoria fu completata includendo le interazioni gravitazionali che erano rimaste fuori dalla prima versione (la relatività ristretta o speciale). Seguirono numerose verifiche, alcune anche in tempi recenti, sostanzialmente tutte confermarono i presupposti e le elaborazioni teoriche.

La relatività speciale contiene un fondamento teorico a cui è legato un aneddoto interessante; poco prima di consegnare all’editore gli articoli, Einstein ebbe un ripensamento: mise una postilla ed inserì una nota a margine, facendo nascere così un’equazione destinata alla celebrità:

E=mc2

Con essa si dichiara che energia e massa sono la stessa cosa, che una piccola massa è anche una grande energia e viceversa ed anche che la velocità della luce è la costante matematica per passare dal sistema fisico denso a quello energetico, (c al quadrato ha un significato dimensionale in un sistema coerente di unità di misura e non implica il superamento di c medesimo).

Dunque un vero e proprio passaggio di stato, simile, pur non uguale, a quelli della chimica, per cui ad esempio acqua, ghiaccio e vapor d’acqua sono tre “versioni” di una sola realtà.

Circa cinquant’anni dopo, la drammatica applicazione dell’equazione pose termine al secondo conflitto mondiale, liberando l’energia compattata nei nuclei atomici della massa fissile.

Come già detto nel 1916 uscì la versione completa della teoria, ci vollero dieci anni che Einstein, nelle sue memorie, definì di duro lavoro, grazie al quale egli riuscì ad includere anche la gravità che diventava l’effetto della modifica della curvatura dello spazio da parte delle masse. Lo spazio vuoto diveniva così una trama che accoglie i corpi, deformando localmente la propria simmetria ed attirando altre masse minori in una sorta di depressione. La teoria della gravitazione universale, risalente ad Isaac Newton, subì quindi una fondamentale integrazione, relativa alla natura della forza e dello spazio stesso. Una delle conseguenze previste era che anche la radiazione elettromagnetica, cioè le particelle subatomiche, subisse l’effetto del mutare della simmetria spaziale in presenza di corpi molto massivi; ma ciò non era ancora dimostrato.

Ancora un volta ci si rivolse al cielo… Molti astronomi cercarono la conferma o la smentita della nuova gravità, osservando l’universo sia nelle frequenze del visibile sia in quelle delle onde radio, osservazioni che negli anni migliorarono grazie allo sviluppo delle nuove tecnologie.

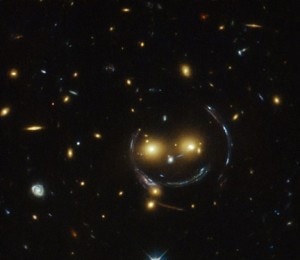

Già nel 1919, nel corso di un’eclissi totale di sole si ebbe una prima conferma, osservando che la disposizione reciproca di alcune stelle prossime al Sole, temporaneamente oscurato, era diversa da quella osservabile quando la nostra stella ne era lontana (in senso relativo alla prospettiva terrestre, naturalmente); ma la prova definitiva, a suo modo spettacolare ed emozionante, si ebbe all’inizio degli anni ottanta del XX secolo con l’osservazione e la documentazione fotografica, della prima lente gravitazionale.

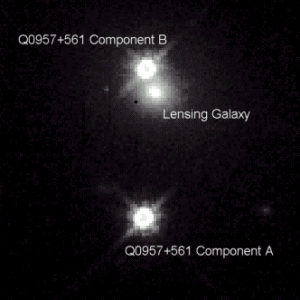

Le “Quasar” sono “oggetti” del cielo profondo che emettono in modo discontinuo molta energia elettromagnetica, oggi si ritiene che siano galassie remote di cui percepiamo i nuclei estremamente energetici come stelle puntiformi. La storia comincia con l’osservazione di un sistema di due quasar troppo simili per essere vere, infatti il loro percorso evolutivo avrebbe dovuto essere identico, cosa, poco provabile, inoltre i loro spettri di emissione e di assorbimento, nella banda visibile, non avevano differenze: per entrambe le quasar vi erano le medesime tracce dovute all’attraversamento di una nube cosmica, fatto inspiegabile considerando che i due “oggetti” sarebbero stati vicini, si, ma comunque distanti anni luce.

Come sempre accade nella ricerca, le incongruenze attirano l’attenzione e la coppia celeste divenne sorvegliata speciale. I radiotelescopi ed i telescopi ottici più potenti del pianeta iniziarono a sondare quel settore di cielo; infatti vi erano fondati motivi per ritenere che, in accordo con la relatività generale, la quasar reale fosse solamente una, mentre l’altra risultasse dallo sdoppiamento dell’immagine dovuta alla presenza di una grande massa in grado di deviare parte dei raggi luminosi prima del loro arrivo sulla Terra. Mancava però questo oggetto molto massivo, che, infine, dopo qualche indizio nelle radio immagini, fu ben definito, nella gamma visibile, tra la quasar reale e quella virtuale dal telescopio ottico di Manua Kea nelle isole Hawaii, in condizioni osservative ideali: una galassia ellittica a debole emissione elettromagnetica, quindi quasi invisibile, a circa metà strada tra la quasar vera e la terra. L’immagine di questo scenario venne filtrata e migliorata al computer; oggi possiamo dire che ottant’anni dopo la sua prima formulazione, la teoria della relatività veniva fotografata sotto forma di deformazione della simmetria spaziale, agente anche su particelle di massa infinitesima o nulla come i fotoni.

Seguirono numerose verifiche tra cui quella della comparazione dei picchi di brillantezza dei due (virtuali) corpi celesti; si determinò che quando un evento del genere si osserva sulla quasar reale, dopo 417 giorni terrestri si ripete, identico nella sua immagine, vale a dire che i fotoni deviati compiono un percorso maggiore di circa un anno terrestre prima di giungere ai nostri occhi.

Da questa scoperta (sigla astronomica del sistema Q0597+561) iniziò a svilupparsi, come nuova branca dell’astronomia, la geometria gravitazionale che permise di scoprire altre forme di deflessione ottica, già previste dalla teoria, migliorando la possibilità umana di applicar misure, facendo triangolazioni pur nel campo infinito dell’universo; esso svelava così, su una voluta superiore a quella dell’etere luminifero, la sua trama continua.

La relatività e la fisica quantistica non hanno mai parlato un linguaggio comune, sebbene la seconda fu tributaria della prima. Einstein, fece in tempo a veder sorgere lo strano universo dei quanti, scrisse, a proposito del metodo probabilistico di quest’ultima:

“Vi è un notevole contenuto di verità. Ma non posso credere seriamente in essa, perché la teoria che ne deriva è incompatibile con il principio che la fisica debba essere la rappresentazione di una realtà nel tempo e nello spazio, senza assurdi effetti a distanza“.

Ecco, il cuore della questione: l’effetto a distanza non mediato, vale a dire immediato, nell’ambito di un sistema coerente, preso nel suo insieme e non per una sua particolarità locale. Non siamo abituati a questo genere di interazioni non mediate, oggi meno di ieri, tanto da escluderle dai ragionamenti, forse condizionati proprio da questa epoca dei “Media”, (che sono poi le varie applicazioni tecnologiche di un unico medium, l’elettromagnetismo); eppure la stessa relatività, abbiamo visto, ammonisce a non scambiare la percezione locale con la realtà.

John Stewart Bell fu un fisico delle particelle che formalizzò in veste matematica e sperimentale il principio di “non località”; nel 1990 fu nominato per il premio Nobel ma concluse il suo ciclo nello stesso anno. Egli fu un grande teorico ma anche uno scienziato sperimentale degli acceleratori di particelle. Riuscì a dimostrare che due quanti, appartenenti allo stesso sistema (atomo) e con caratteristiche complementari, come ad esempio il verso di rotazione (spin), pur allontanate di metri mantengono una reciproca interdipendenza, tale che, se viene modificato la spin dell’una si modifica istantaneamente, in modo complementare, anche quello dell’altra. Occorre tener conto dei fattori di scala: le due particelle non possono che allontanarsi alla velocità della luce e la distanza di una decina di metri equivale, nel nuovo sistema, a distanze siderali.

In un convegno del 1984 Bell auspicò che si iniziasse a riflettere seriamente sul non localismo della fisica quantistica ed il localismo della relatività, sostenendo che una vera integrazione tra i due filoni di ricerca avrebbe richiesto, oltre ad un progresso tecnologico, un profondo rinnovamento concettuale.

La teoria astronomica dell’universo in espansione, testimoniata dello spostamento verso la banda del rosso degli spettri di emissione di tutti i corpi celesti osservabili, induce a considerare che le particelle costituenti l’universo, prima della grande esplosione, fossero confinate in un unico sistema estremamente denso, quindi, ora, ogni sito, in senso non locale, sarebbe collegato a qualsiasi altro, in modo “non mediato” cioè: immediato. Ma e immaginabile un universo che nella sua trama più intima sia non locale, ma non lo sia anche, a qualche titolo, oltre la ribalta della coscienza umana, nel macrocosmo? Là dove i quanti lasciano il loro abito energetico ed indossano quello massivo, edificando gli atomi e con essi le forme minerali e biologiche, dall’essere più infimo su verso il cielo popolato dai corpi celesti. La percezione legata alla coerenza locale è, forse, troppo miope per far risaltare la realtà, ammesso che ne esista una sola, essendo, per la fisica dei quanti, lo stesso atto osservativo a farla precipitare in una certa forma. Il grande protagonista della conoscenza fisica odierna sta, sempre più, diventando lo “Spazio”, ben oltre il concetto di contenitore vuoto, e le interazioni che esso accoglie. Di questo nuovo spazio cercheremo di occuparci in futuro.

Un ritorno al suono?

Viene chiamata “Teoria delle stringhe” ma in italiano meglio sarebbe definirla: “Teoria delle corde vibranti”. Per noi che abbiamo praticato il mondo del suono (e che siamo giunti sin qui partendo da lì) ciò ha un significato straordinariamente evocativo. Questa teoria è frutto del tentativo di unificare le precedenti, teorizzando un punto di partenza comune: un luogo, meglio ancora un super-luogo, in cui filamenti infinitesimi di energia vibrando generano i quanti corrispondenti alle varie frequenze di vibrazione (o lunghezze di corda). Questo super-luogo, sarebbe il vero spazio, di cui la relatività conoscerebbe alcuni bagliori. Esso, per coerenza matematica con con le teorie già consolidate, dovrebbe contenere altre sette dimensioni, oltre alle tre note, ed a quella temporale. Necessitano ancora verifiche teoriche e sperimentali: i lavori sono in corso.

Lo sviluppo del progresso scientifico non sempre segue un percorso rettilineo, ma ne segue uno, ed a posteriori, osservandone le tracce, emerge in filigrana un disegno, che, pur nelle diverse circostanze, sempre ritrae il proposito umano di conoscere, quello stesso che ciascuno, scienziato o non, si porta in cuor proprio.

Così per questo lungo percorso in cui furono impegnate le migliori risorse mentali dell’umanità, la scienza riuscì a trarsi dalle paludi della contesa tra il modello continuo dell’Universo e quello discreto. giungendo a definire la rete di relazioni mediate ed immediate che lo costituiscono, anzi che sono Universo stesso; nel quale persino ogni piccolo pensiero umano, come il rumore di foglia che cade dal ramo, ha la sua rilevanza.

all’esperimento M&M alla coerenza non locale; da una realtà fissa ed immutabile, ad un’altra che la stessa pressione dell’osservazione può modificare, ridefinendo il Reale.

Ora è tempo di ritornare al suono fisico con questo stralcio dalla raccolta DeHartmann/Gurjeff: toni (o forse quanti?) consonanti e dissonanti che si rincorrono sul pentagramma.

Journey to Inaccessible Places IX

Pingback:La misura delle cose | TPS Blog – Area italiana